怒了!她家人的聲音被AI合成帶貨!已有多人受騙→

近日社交平臺上出現了不少AI生成的視頻

全紅嬋的“爸爸”“哥哥”紛紛出鏡

邊講述邊帶貨

還有不少人被騙下單

究竟是誰在冒充奧運冠軍的家人?

AI仿冒詐騙

還有多少受害者?

“AI仿冒”家人

帶貨文案雷同

近日

有賬號在社交平臺發布圖文作品

稱為奧運冠軍全紅嬋家承建新房

且即將開工

並在評論區回應網友消息

“千真萬確”

據悉,此前在接受媒體采訪時,全紅嬋媽媽曾表示,自己的願望是在村裏蓋一個房子,讓孩子們回來能有房間住。

關於全紅嬋家建造新房消息是否屬實,記者求證了廣東湛江市麻章區政府相關部門及自稱承建新房方,截至發稿,尚未得到明確回應。

然而,在社交平臺上已經出現多個賬號使用AI合成的全紅嬋爸爸、哥哥聲音,用完全相同的文案介紹家裏要蓋新房,以此來博取流量。

在AI合成視頻中攜帶有駱駝奶粉、土雞蛋、洗衣液等多種商品鏈接,流量較好的仿冒作品評論區中,不乏有人被騙下單購買。

全紅嬋父母與哥哥。圖源:九派新聞

據悉,全紅嬋的父母長期靠種植水果維持生計,全紅嬋的大哥全進華是一名三農主播,帶貨湛江本地的特產水果,全紅嬋的母親也時常入鏡,全家人直播帶貨曾引發不少網友的質疑。

對此,全進華在采訪中表示,自己做自媒體是想帶動三農產品銷售,當地種了很多水果,有時會出現滯銷的情況,自己想幫助果農。與此同時,自媒體工作也可以讓他兼顧照顧身體不好的母親。

他說:“雖然我還不是個(流量)很大的博主,也不一定能賣出很多東西,但我希望盡自己能力幫助家人、村裏乃至湛江以及其他地方的農產品進行銷售。”

換臉、換聲音

多名公眾人物陷入“AI漩渦”

利用AI偽造視頻的

現象並不罕見

此前

曾有多位明星

成為AI偽造視頻的素材

今年3月,有線上遊戲平臺利用AI技術,將知名演員的肖像、聲音及過往視頻片段,合成制作為帶有賭博性質的代言宣傳片。這些AI合成的視頻顯示,演員講代言臺詞的聲線和口音聽得出均刻意模仿本人,整體畫面制作頗為粗糙,藝人講臺詞的嘴形僵硬不自然,AI合成痕跡十分明顯。

3月5日,相關演員經紀公司先後發布聲明,指出該宣傳片為合成影片,否認其與有關遊戲平臺合作或代言、推廣它們的業務,提醒各方人士不要輕信,以免上當受騙。

除了明星

當普通人成為公眾人物

隨著流量的上漲

也會被別有用心之人盯上

2023年,謝嶽為尋找兒子發出千萬尋子的懸賞而登上熱搜,走入公眾視野,2025年3月14日,謝嶽尋子成功,再次引發了廣泛關註。3月16日,在謝嶽舉辦的認親團圓宴上,來了許多媒體和自媒體人員,甚至有人不聽勸阻,現場架起手機直播帶貨。

謝嶽在公共場合舉著尋子告示

不僅如此,一些不良商家甚至利用謝家父子形象用AI生成帶貨視頻。據報道,在某短視頻平臺,一些商家或個人賬號剪輯謝嶽、謝浩男此前的直播視頻畫面,利用AI對口型讓他們“說出”所謂“送福利”的內容,並在視頻內掛購物鏈接,制作帶貨視頻,帶貨的商品包括面膜、牙膏等。

謝浩男在某短視頻平臺上

註冊了唯一認證賬號

他曾表示

接下來自己會繼續讀書

承諾不會帶貨

並稱網上所謂的“帶貨視頻”

都是假的

對此,河南澤槿律師事務所主任付建表示,商家剪輯尋親者相關視頻,利用AI技術制作帶貨視頻推銷商品,侵犯了當事人的肖像權。民法典規定,任何人未經授權不得擅自使用他人肖像,民法典中規定了對自然人聲音的保護參照適用肖像權保護的有關規定。如果有商家利用AI對口型功能讓尋親者帶貨,若公眾能根據音色、語調和發音風格等識別出是他們的聲音,也侵犯了其聲音等具有可識別性質的人格權益。商家需向被侵權人承擔停止侵害、消除影響、賠禮道歉、賠償損失等民事責任。

換臉、換聲詐騙

老年用戶難辨真假

記者了解到

近年來

全國發生了多起

通過“AI換聲”實施詐騙的案件

日前

有不法分子通過“AI換聲”

仿冒一位老人的孫子

以“打人須賠償

否則要坐牢”為由

詐騙老人2萬元

受訪專家介紹,AI能夠“克隆”聲音,主要是依靠深度學習算法,即短時間內從采集的聲音樣本中提取關鍵特征,包括頻率、音色、聲調、語速、情感等,將這些特征記錄為數學模型,再通過算法合成。

中國科學院自動化研究所模式識別實驗室工程師牛少東說,隨著算法越來越先進,在高性能設備和高精度模型的加持下,AI生成的語音內容從兩年前的“一眼假”升級到如今的“真假難辨”。

大四學生耿孝存最近經常在網絡音樂播放器中收聽幾首翻唱歌曲,他一直以為這些歌曲由某知名女歌手翻唱,後來才得知其實全部是AI合成的。“聲音逼真到我從來沒懷疑過。”耿孝存說。

AI聲音在最近一兩年時間內變得格外“流行”。清華大學新聞與傳播學院教授沈陽說,人工智能技術的普及,讓AI模擬聲音的門檻大幅降低。通過一些開源軟件和平臺,沒有專業知識的普通用戶也能操作。

大量App

能夠進行AI合成聲音

最快只需十幾秒

記者在應用商店搜索發現

相關App有數十款

下載量最高超千萬次

記者聯系了一款App的客服人員,對方表示,花198元就能解鎖付費會員,對著鏡頭說幾遍“12345”,AI就會根據聲音生成各類內容的出鏡口播視頻。記者操作後發現,通過這款軟件生成的名人聲音,基本可以以假亂真,且錄入名人聲音不需要提供任何授權證明。

業內人士告訴記者,AI模擬人聲在互聯網“流行”,有追逐流量和變現的目的。通過“克隆”名人聲音制作的惡搞、獵奇類視頻,在相關平臺播放和點贊量均不低,有的甚至還被推上熱搜。發布者也相應獲得流量曝光、粉絲增長、廣告收入等播放收益。

“偷”人聲音也有不法利益驅動。國家金融監管總局2024年7月發布的《關於防範新型電信網絡詐騙的風險提示》中提到,不法分子可能對明星、專家、執法人員等音視頻進行人工合成,假借其身份傳播虛假消息,從而實現詐騙目的。

多舉措強化治理

新規9月起施行

用AI生成他人聲音

是否違法違規?

多位受訪專家表示

個人聲音中包含的聲紋信息具備可識別性,能以電子方式記錄,能關聯到唯一自然人,是生物識別信息,屬於個人信息保護法規定的敏感個人信息之一。

2024年4月,北京互聯網法院宣判全國首例“AI聲音侵權案”,明確認定在具備可識別性的前提下,自然人聲音權益的保護範圍可及於AI生成聲音。該法院法官認為,未經權利人許可,擅自使用或許可他人使用錄音制品中的聲音構成侵權。

近年來,有關主管部門出臺《人工智能生成合成內容標識辦法(征求意見稿)》《互聯網信息服務深度合成管理規定》《生成式人工智能服務管理暫行辦法》等規定,一定程度上給AI技術使用劃定了紅線。

關於人工智能應用產生的造謠侵權、刑事犯罪、道德倫理等問題,建議有關部門細化完善相關規則,通過典型案例、司法解釋等方式給予更為明確的規範指引,厘清法律法規邊界。

需進一步強化人工智能倫理規制,超前部署人工智能風險研究,提前預判人工智能技術應用可能帶來的社會影響。

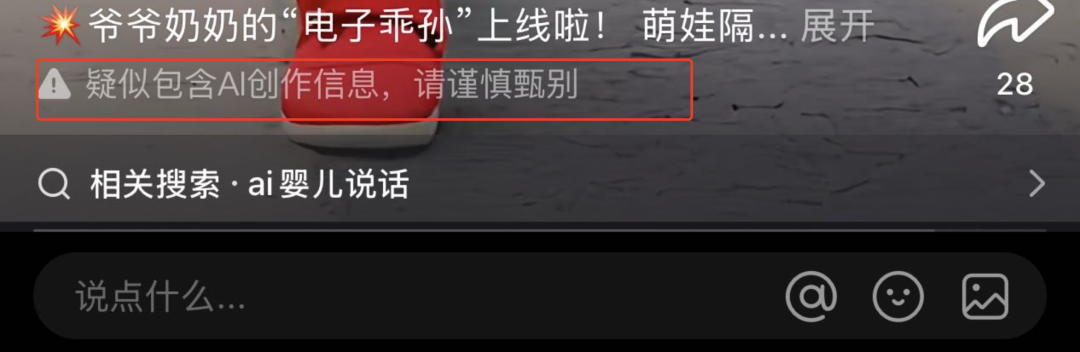

近日,國家互聯網信息辦公室等四部門聯手發布了《人工智能生成合成內容標識辦法》(簡稱《標識辦法》),並定於2025年9月1日起正式施行。

《標識辦法》明確了服務提供者應當對文本、音頻、圖片、視頻、虛擬場景等生成合成內容添加顯式標識,在提供生成合成內容下載、復制、導出等功能時,應當確保文件中含有滿足要求的顯式標識;應當在生成合成內容的文件元數據中添加隱式標識。

有媒體評論稱,這一舉措,為AI生成內容設定了明確的標識規範,使得以往難以辨別的AI作品必須“持證上崗”,清晰標註其AI生成身份。不僅在AI作品與人類創作之間劃清了界限,有效解決了AI作品帶來的信任問題,讓AI作品從隱匿於人群之中回歸其專屬領域,為社會營造了一個純凈的創作環境。

你刷到過這些“AI魔改”視頻嗎?

你怎麽看?